Archiwum Instytutu Józefa Piłsudskiego kryje niejedną tajemnicę i choć obecnie wszystkie zbiory są powszechnie dostępne i każdy kto interesuje się historią może bez ograniczeń z nich korzystać, to jeszcze w niedawnej przeszłości niektóre z dokumentów były utajnione. Doskonalym przykładem jest kolekcja “Estezet”, przekazana Instytutowi przez byłego dyrektora wykonawczego, Mariana Chodackiego.

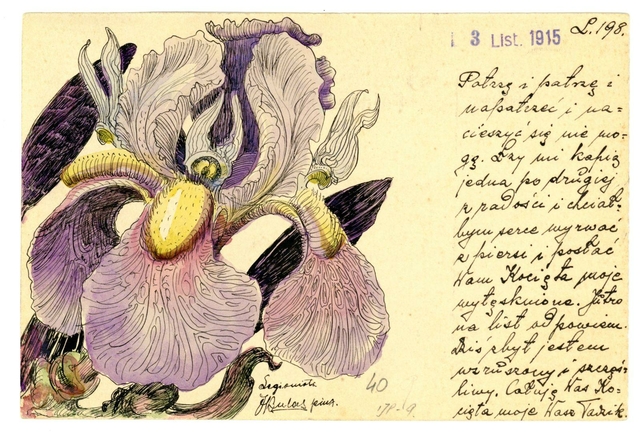

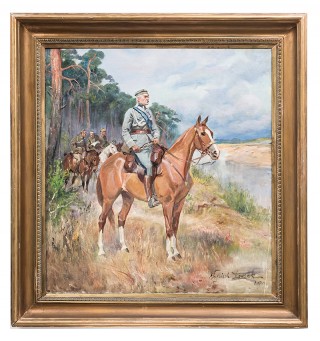

Marian Chodacki w okresie legionowym 1915r. Archiwum IJP w Ameryce

Marian Chodacki w okresie legionowym 1915r. Archiwum IJP w Ameryce

Ze względu na ryzyko dostania się ściśle tajnych informacji w niepożądane ręce, łącznie z personaliami agentów polskiego wywiadu, przez lata kolekcja “Estezet” była ukrywana i dostępna tylko osobom wtajemniczonym. Dokumenty z kolekcji dotyczą działalności polskiego wywiadu w Ameryce Południowej i Północnej, w latach 1941-1945. Placówka działała pod przykrywką w Konsulacie Generalnym RP w Nowym Jorku.